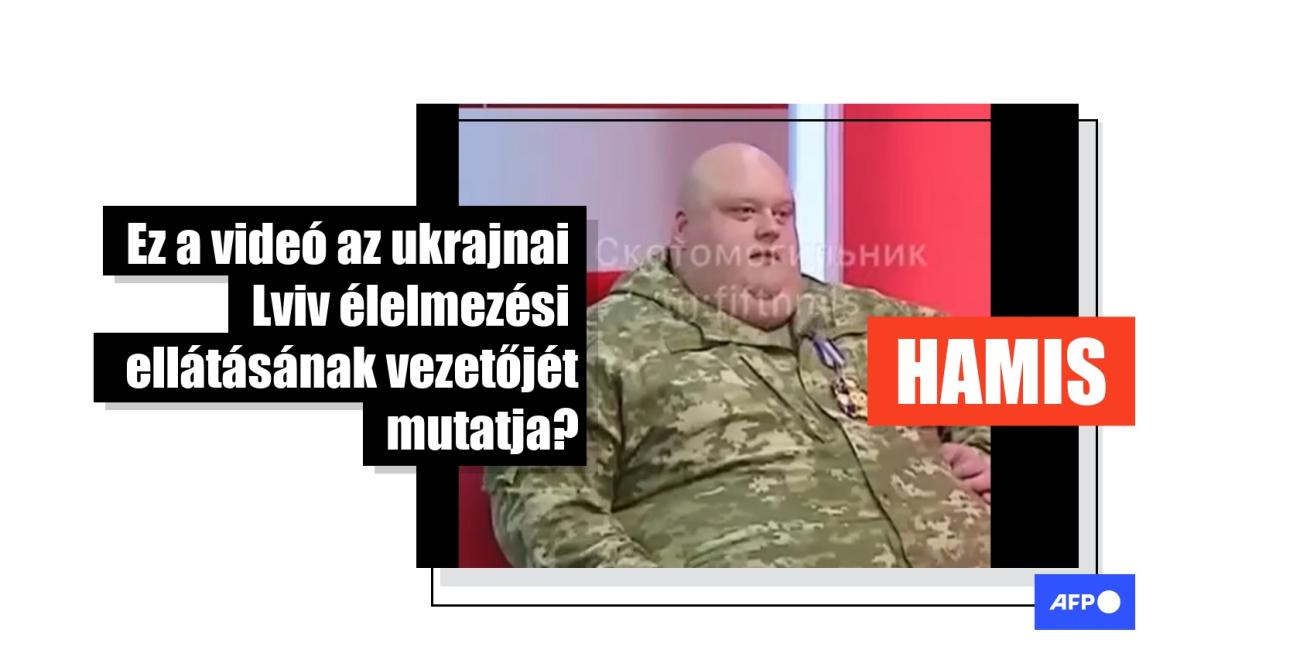

Mesterséges intelligenciával készült ez a videó, melyen "ukrán katonák megadják magukat"

- Megjelent: 2025. november 7., 16:39

- 4 perces olvasmány

- Szerző: Ede ZABORSZKY, AFP Hungary

Oroszország Ukrajna elleni teljes körű inváziójának negyedik évében az online térben továbbra is terjednek azok a dezinformációs narratívák, amelyek célja a nyugati támogatás aláásása. Ebben az összefüggésben több nyelven, többek között magyarul is terjedni kezdett egy videó, melyen állítólag ukrán katonák tömeges megadását látni. A videó azzal az állítással terjed, hogy a nyugati megfigyelők nem ismerik el az ukrán hadsereg moráljának romlását, miközben az Oroszország ellen vívott háború egyre csak elhúzódik. De a valóságban a síró katonákat ábrázoló videót a Sora nevű mesterséges intelligencia programmal hozták létre. A program vízjele többször is látható a videóban, és a vizuális nyomok és a digitális hangelemzés is megerősíti, hogy az mesterséges intelligenciával készült.

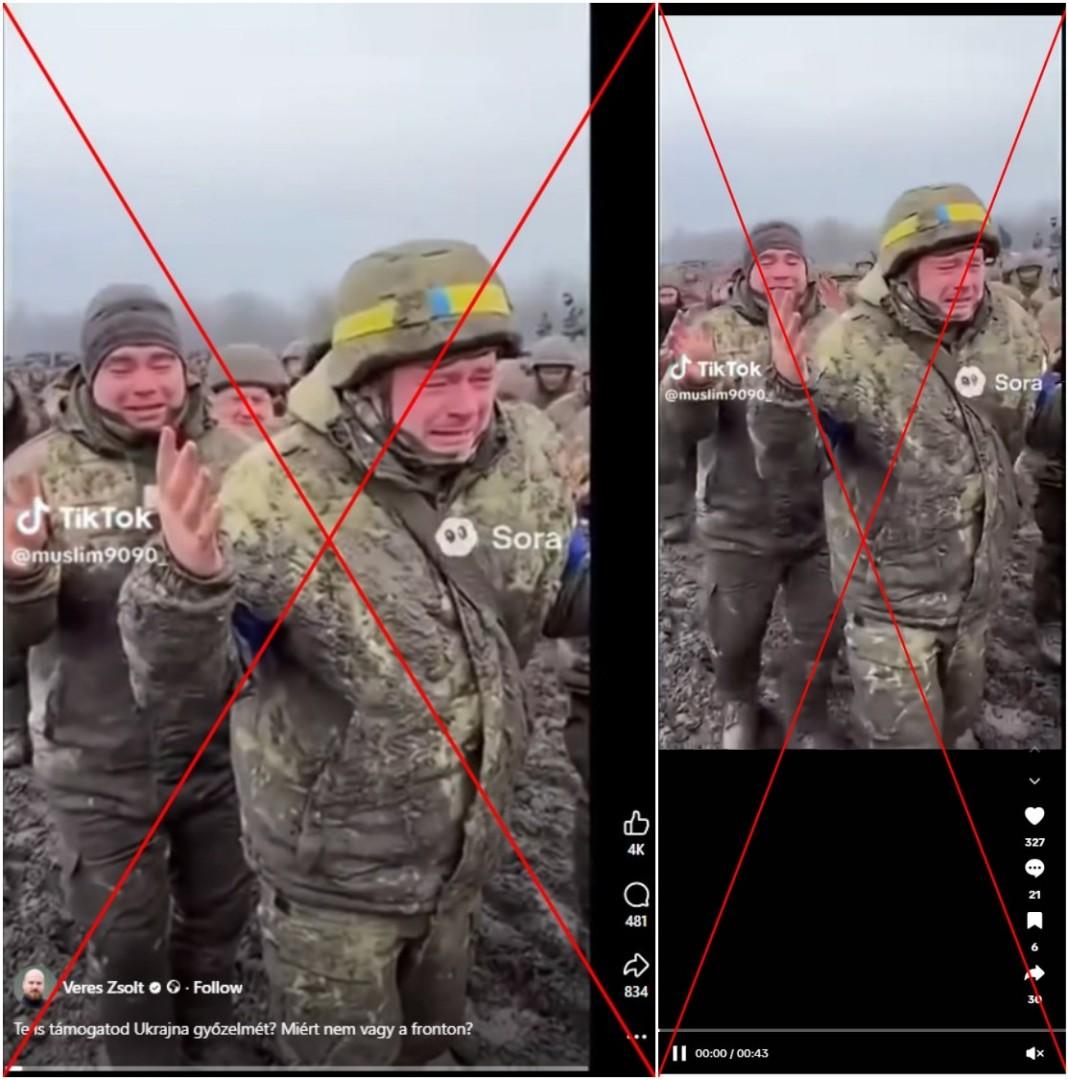

„Te is támogatod Ukrajna győzelmét? Miért nem vagy a fronton?” – olvasható egy magyar nyelvű Facebook-videó leírásában, amit 2025. november 3. óta már több mint 800-szor osztottak meg.

A felvételeken síró katonákat látni egy sáros környezetben, akik közül néhányan az ukrán nemzeti színeket viselik az egyenruhájukon. A videóban kiabálás és sírás hallható, és egy hang azt mondja, hogy meg akarják adni magukat.

A klip ezután átvált a videót feltöltő férfire, aki azt mondja, hogy amíg egyes nemzetek fegyverekkel és pénzzel támogatják Ukrajnát, „ezek a katonák sírva vonulnak, nekik elegük van a harcból”. Ugyanez a felhasználó a videót TikTokra is feltöltötte.

A videó, melyen állítólag magukat megadó ukrán katonákat látni, más nyelveken is terjedni kezdett, többek között angolul, olaszul, bolgárul, románul és vietnámiul.

Ehhez hasonló videók más nyelveken, például szlovákul, csehül és lengyelül is megjelentek a közösségi médiában, ugyanezzel az állítással. Ezek a felvételek ugyanazt a vízjelet és közösségi média felhasználónevet tartalmazzák, mint a fenti változat.

Más, vizuálisan nagyon hasonló videók is megjelentek az interneten 2025 november elején, azzal az állítással, hogy azokon ukrán katonákat látni, ahogyan megadják magukat Pokrovszk város közelében. Ezeket a videókat a Lead Stories tényellenőrző szervezet már cáfolta (itt archiválva), és megállapították, hogy a videók az OpenAI Sora nevű szoftverével, mesterséges intelligenciával készültek.

Pokrovszk egy erődváros Ukrajna Donyeck régiójában, amely az ukrán hadsereg egyik fő utánpótlási útvonalán fekszik, és több mint egy éve Moszkva célkeresztjében van (itt archiválva). Az amerikai Institute for the Study of War (ISW) háborúkutató intézet által közzétett harctéri térképek szerint az orosz erők egy átkaroló hadművelettel közelednek a város külvárosához. Pokrovszk elfoglalása jelentős propaganda-győzelem lenne a Kreml számára.

Oroszország elutasította az Egyesült Államok felhívását, hogy állítsa le támadásait Ukrajna ellen, és ehelyett folytatta a szárazföldi offenzívát.

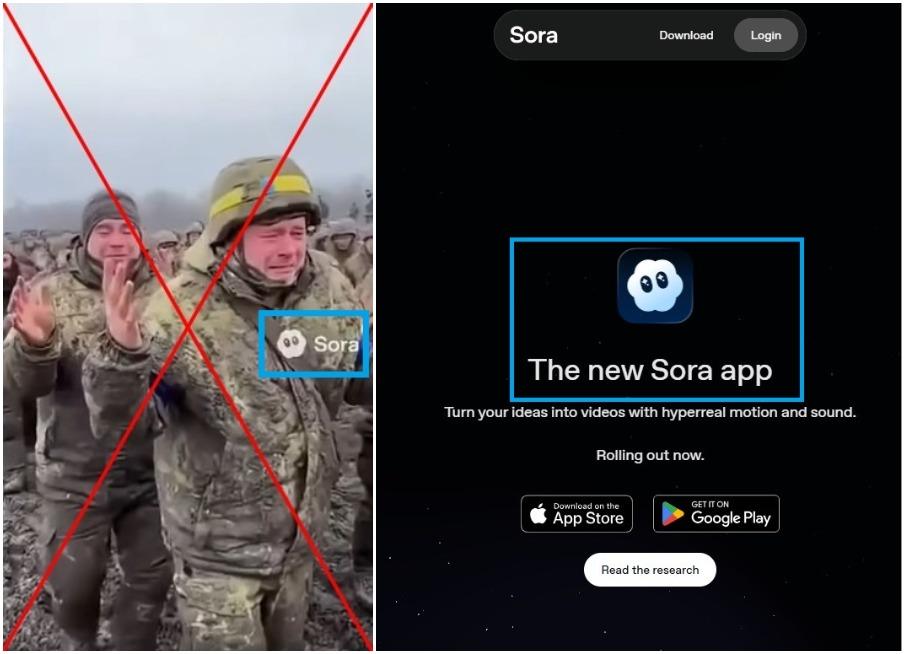

De a közösségi médiában terjedő videó, amin melyen katonák látszólag megadják magukat, mesterséges intelligenciával készült. A videón a Sora vízjel látható, és a hangsáv digitális elemzése is kimutatta, hogy az mesterséges intelligenciával készült.

Mesterséges intelligenciával létrehozott videó

A videóban egy vízjel ugrál körbe a képernyőn: egy kis felhő szemekkel és a „Sora” felirattal.

A Sora az OpenAI szövegből-videó modellje, amely szöveges „ötleteket hiperreális mozgással és hanggal rendelkező videókká alakít át”.

Van néhány árulkodó vizuális nyom a videóban, amely jellemző az AI-ra: az egyik korai képkockán egy katona sisakján egy kis bemélyedés látható.

A későbbi képkockákon a bemélyedés mélyebbé válik, és a sisakja egyre inkább egy védőszemüvegre kezd hasonlítani. A különböző tárgyak transzformálódása egymásba gyakori jelenség az AI által generált videókban.

A háttérben látható néhány arc pedig elmosódottnak vagy természetellenesnek tűnik, amint az az alábbi nagyított képernyőképen látható:

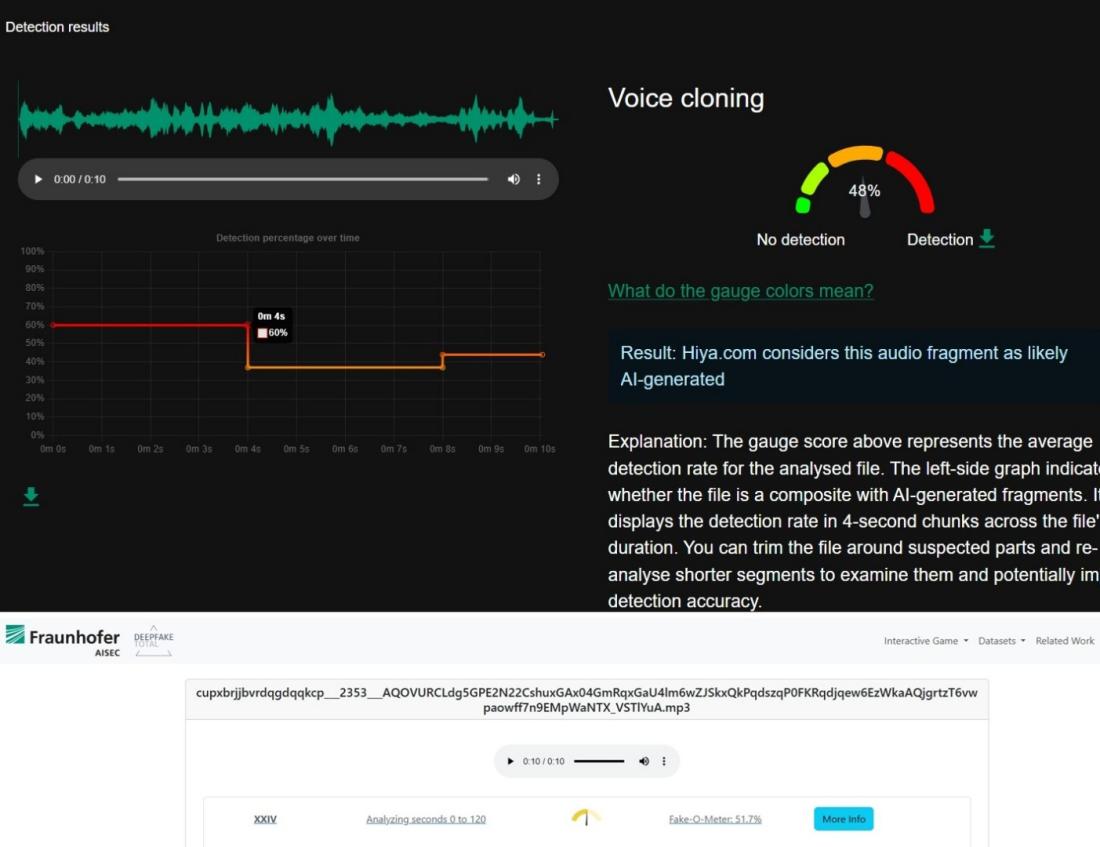

Az InviD-WeVerify tényellenőrző böngésző-kiterjesztésben elérhető Hiya audióelemző szoftver, és a Frauenhofer Intézet Deepfake Total programja is azt mutatták, hogy a videó hangsávja mesterséges intelligenciával készült. Az audiofájlok esetében az 50 százalékos érték már nagy bizonyosságot jelent abban, hogy a tartalom részben vagy egészében MI-vel készült.

A klip eredete

A közösségi médiában terjedő videó legtöbb verziója a “muslim9090_” TikTok-felhasználónevet tartalmazza.

Ez a profil 2025. november 6-án már nem volt elérhető a videomegosztó oldalon, de a Google-ben a felhasználó néhány TikTok-videójának az indexelt változata még mindig megjelenik miniatűr előnézettel.

Ezek a klipet külsőre hasonlítanak a többi videóhoz, amik kapituláló katonákat mutatnak, de a kis előnézeti képből nem lehet megmondani, hogy ezeket is mesterséges intelligenciával készültek-e. Amikor rákerestünk a videók Google-ben megjelenő címére, további hasonló videók előnézeti képeit találtuk egy másik, már nem elérhető TikTok-fióktól, amelynek hasonló felhasználóneve volt: „wuslim06”.

A TikTok november 7-én e-mailben megerősítette az AFP-nek, hogy ezeket a felhasználókat az AI-vel generált tartalom használatára vonatkozó közösségi irányelveik megsértése miatt eltávolították.

Az AFP további tényellenőrzései az ukrajnai háborúval kapcsolatban itt találhatók.

Szerzői jog © AFP 2017–2026. A tartalom kereskedelmi célú felhasználásához előfizetés szükséges. Kattintson ide, ha többet szeretne megtudni.

Van olyan tartalom, amelyet szeretne ellenőrizni az AFP tényellenőrzésén keresztül?

Lépjen kapcsolatba velünk